Optimierung durch Crawling und Indexierung: Wie Suchmaschinen Ihre Website finden und einordnen

Crawling und Indexierung: Wie Suchmaschinen Ihre Website entdecken und einordnen

Wenn Sie eine Website betreiben, möchten Sie sicherstellen, dass sie von potenziellen Besuchern gefunden wird. Eine Möglichkeit, dies zu erreichen, ist die Optimierung Ihrer Website für Suchmaschinen. Doch wie funktioniert das eigentlich? Zwei wichtige Schritte sind das Crawling und die Indexierung Ihrer Website.

Was ist Crawling?

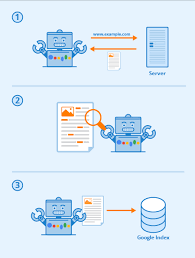

Crawling bezieht sich auf den Prozess, bei dem Suchmaschinen automatisch durch das Internet navigieren und Websites finden. Dabei nutzen sie sogenannte Bots oder Spiders, die Links auf einer Seite folgen und so von einer Seite zur nächsten gelangen. Sobald sie eine neue Seite finden, fügen sie diese in ihren Index ein.

Es ist wichtig zu beachten, dass Bots nicht alle Websites im Internet finden können. Einige Seiten können aus verschiedenen Gründen blockiert sein oder es kann einfach kein Link zu ihnen existieren. Es ist daher wichtig sicherzustellen, dass Ihre Website für Bots zugänglich ist.

Was ist Indexierung?

Indexierung bezieht sich darauf, wie Suchmaschinen Ihre Website in ihren Index aufnehmen. Der Index ist eine riesige Datenbank mit Informationen über alle Websites im Internet. Wenn eine Suchanfrage gestellt wird, durchsucht die Suchmaschine den Index nach passenden Ergebnissen.

Um Ihre Website in den Index aufzunehmen, muss der Bot zunächst Ihre Seite crawlen. Sobald er dies getan hat, analysiert er den Inhalt der Seite und ordnet ihn entsprechend ein. Dies geschieht anhand verschiedener Faktoren wie Keywords, Meta-Tags und internen Links.

Wie können Sie Crawling und Indexierung verbessern?

Es gibt verschiedene Möglichkeiten, um sicherzustellen, dass Ihre Website von Suchmaschinen gefunden und in den Index aufgenommen wird. Hier sind einige Tipps:

- Stellen Sie sicher, dass Ihre Website für Bots zugänglich ist. Vermeiden Sie blockierende Elemente wie Flash oder Java-Script.

- Sorgen Sie für eine klare und logische Struktur Ihrer Website. Dies erleichtert es Bots, Ihre Seite zu crawlen und zu indexieren.

- Verwenden Sie relevante Keywords in Ihrem Inhalt und in Ihren Meta-Tags.

- Erstellen Sie hochwertigen Content auf Ihrer Seite, der von anderen Websites verlinkt wird.

- Nutzen Sie interne Links auf Ihrer Seite, um eine klare Hierarchie und Navigation zu schaffen.

Zusammenfassend lässt sich sagen, dass Crawling und Indexierung wichtige Prozesse sind, um Ihre Website für Suchmaschinen zu optimieren. Durch die Umsetzung einiger grundlegender Tipps können Sie sicherstellen, dass Ihre Website leichter gefunden wird und höher in den Suchergebnissen erscheint.

6 Vorteile von Crawling und Indexierung für eine bessere Suchmaschinenoptimierung

- Es ermöglicht eine bessere Suchmaschinenoptimierung, um die Sichtbarkeit der Website zu verbessern.

- Crawling und Indexierung helfen, den Content auf der Website zu organisieren und zugänglich zu machen.

- Es stellt sicher, dass Suchmaschinen den Inhalt Ihrer Website vollständig verstehen können.

- Es macht es leichter für Benutzer, relevante Informationen in weniger Zeit zu finden.

- Crawling und Indexierung ermöglichen es Suchmaschinen, Websites schneller als je zuvor zu durchsuchen und neue Ergebnisse anzuzeigen.

- Sie helfen bei der Erkennung von Duplikaten oder ähnlichem Content sowie beim Entfernen unerwünschter Elemente aus dem Index der Suchmaschine

Sechs Nachteile von Crawling und Indexierung: Zeitintensität, hohe Kosten, mögliche Schäden an Webseiten, unerwünschte Ergebnisse, Sicherheitsrisiken und Schwierigkeiten bei

- Crawling und Indexierung kann sehr zeitaufwändig sein.

- Die Kosten für die Implementierung einer Crawler-Lösung sind oft hoch.

- Unter Umständen können Webseiten durch das Crawling und Indexieren beschädigt werden.

- Eine schlecht implementierte Crawler-Lösung kann zu unerwünschten Ergebnissen führen, da nicht alle Seiten richtig indexiert werden können.

- Es besteht die Gefahr, dass sensible Daten beim Crawling und Indexieren ausgespäht werden könnten, falls keine geeigneten Sicherheitsmaßnahmen getroffen wurden.

- Wenn einmal etwas falsch indexiert wurde, ist es schwer, den Fehler zu beheben oder zu ändern

Es ermöglicht eine bessere Suchmaschinenoptimierung, um die Sichtbarkeit der Website zu verbessern.

Crawling und Indexierung sind wichtige Prozesse für eine erfolgreiche Suchmaschinenoptimierung. Indem Suchmaschinen Bots Ihre Website crawlen und indexieren, können sie den Inhalt Ihrer Seite analysieren und einordnen. Dies ermöglicht es, relevante Keywords und Meta-Tags zu verwenden, um Ihre Sichtbarkeit in den Suchergebnissen zu verbessern.

Durch eine bessere Sichtbarkeit in den Suchergebnissen können mehr potenzielle Besucher auf Ihre Website gelangen. Dies kann zu mehr Traffic, höheren Conversion-Raten und letztendlich zu einem höheren Umsatz führen.

Daher ist es wichtig sicherzustellen, dass Ihre Website für Bots zugänglich ist und dass Sie relevante Keywords und Meta-Tags verwenden. Durch die Umsetzung dieser grundlegenden Tipps können Sie sicherstellen, dass Ihre Website von Suchmaschinen gefunden wird und höher in den Suchergebnissen erscheint.

Crawling und Indexierung helfen, den Content auf der Website zu organisieren und zugänglich zu machen.

Crawling und Indexierung sind wesentliche Prozesse, um den Content auf Ihrer Website zu organisieren und zugänglich zu machen. Indem Suchmaschinen Ihre Website crawlen und indexieren, können sie eine klare Hierarchie Ihrer Seiten erkennen und die Inhalte entsprechend einordnen. Dies erleichtert es Besuchern, Ihre Website zu durchsuchen und relevante Informationen zu finden.

Durch die Verwendung relevanter Keywords in Ihrem Inhalt und in Ihren Meta-Tags können Sie auch sicherstellen, dass Ihre Website bei relevanten Suchanfragen erscheint. Wenn Sie hochwertigen Content auf Ihrer Seite haben, der von anderen Websites verlinkt wird, kann dies auch dazu beitragen, dass Ihre Seite höher in den Suchergebnissen angezeigt wird.

Durch die Umsetzung grundlegender Tipps wie der Schaffung einer klaren Struktur auf Ihrer Website und der Verwendung interner Links können Sie sicherstellen, dass Bots Ihre Seite leichter crawlen können. Dies führt letztendlich dazu, dass Ihre Inhalte besser organisiert und zugänglicher werden.

Insgesamt ist es wichtig, sich bewusst zu sein, wie Crawling und Indexierung funktionieren und wie sie dazu beitragen können, den Content auf Ihrer Website zu organisieren und zugänglich zu machen. Durch die Umsetzung einiger grundlegender Tipps können Sie sicherstellen, dass Ihre Seite von Suchmaschinen gefunden wird und Besuchern eine positive Erfahrung bietet.

Es stellt sicher, dass Suchmaschinen den Inhalt Ihrer Website vollständig verstehen können.

Crawling und Indexierung: Es stellt sicher, dass Suchmaschinen den Inhalt Ihrer Website vollständig verstehen können

Eine der wichtigsten Vorteile von Crawling und Indexierung ist, dass es Suchmaschinen ermöglicht, den Inhalt Ihrer Website vollständig zu verstehen. Wenn Sie eine Website betreiben, ist es wichtig sicherzustellen, dass Ihre Inhalte von Suchmaschinen erkannt und verstanden werden können. Nur so können Sie sicherstellen, dass Ihre Website in den Suchergebnissen angezeigt wird.

Durch das Crawling Ihrer Website können Suchmaschinen alle Seiten auf Ihrer Website finden und analysieren. Dabei werden alle Links und Inhalte auf jeder Seite berücksichtigt. Sobald die Suchmaschine eine Seite gefunden hat, wird sie analysiert und in ihrem Index gespeichert.

Die Indexierung ermöglicht es der Suchmaschine dann, den Inhalt Ihrer Seite zu verstehen und einzuordnen. Durch die Verwendung von Keywords, Meta-Tags und internen Links kann die Suchmaschine besser erkennen, worum es auf Ihrer Seite geht. Dies erleichtert es ihr dann auch, Ihre Seite für relevante Suchanfragen anzuzeigen.

Insgesamt lässt sich sagen, dass Crawling und Indexierung für den Erfolg Ihrer Website von entscheidender Bedeutung sind. Indem Sie sicherstellen, dass Ihre Inhalte von Suchmaschinen vollständig verstanden werden können, erhöhen Sie die Wahrscheinlichkeit einer höheren Platzierung in den Suchergebnissen.

Es macht es leichter für Benutzer, relevante Informationen in weniger Zeit zu finden.

Crawling und Indexierung: Wie Suchmaschinen die Suche nach relevanten Informationen erleichtern

Crawling und Indexierung sind wichtige Prozesse, die dazu beitragen, dass Suchmaschinen relevante Informationen im Internet finden und diese für Benutzer zugänglich machen. Eine der größten Vorteile dieser Prozesse ist, dass sie es Benutzern erleichtern, relevante Informationen in weniger Zeit zu finden.

Dank der Crawling-Technologie können Suchmaschinen das Internet nach relevanten Inhalten durchsuchen und diese in ihrem Index speichern. Wenn ein Benutzer eine Suchanfrage stellt, durchsucht die Suchmaschine ihren Index nach passenden Ergebnissen und präsentiert sie dem Benutzer in Sekundenschnelle.

Dies ist besonders nützlich für Menschen, die schnell Informationen benötigen oder keine Zeit haben, sich durch unzählige Websites zu wühlen. Durch Crawling und Indexierung können sie schnell auf relevante Informationen zugreifen und ihre Zeit effektiver nutzen.

Darüber hinaus ermöglichen es diese Prozesse auch kleinen Unternehmen oder Websites mit begrenztem Traffic, von potenziellen Kunden gefunden zu werden. Indem sie sicherstellen, dass ihre Website für Bots zugänglich ist und relevante Keywords verwendet werden, können sie ihre Sichtbarkeit in den Suchergebnissen erhöhen.

Insgesamt sind Crawling und Indexierung wichtige Schritte für die Optimierung Ihrer Website für Suchmaschinen. Sie helfen nicht nur dabei, Ihre Website für potenzielle Kunden sichtbarer zu machen, sondern erleichtern auch die Suche nach relevanten Informationen für Benutzer.

Crawling und Indexierung ermöglichen es Suchmaschinen, Websites schneller als je zuvor zu durchsuchen und neue Ergebnisse anzuzeigen.

Crawling und Indexierung: Schnelle Ergebnisse für Suchmaschinenbenutzer

Crawling und Indexierung sind wichtige Prozesse, die Suchmaschinen wie Google dabei helfen, Websites schneller als je zuvor zu durchsuchen und neue Ergebnisse anzuzeigen. Das bedeutet, dass Benutzer von Suchmaschinen schneller relevante Informationen finden können.

Durch Crawling können Suchmaschinenbots automatisch durch das Internet navigieren und Websites finden. Sobald sie eine neue Seite gefunden haben, wird sie in den Index aufgenommen. Dieser Index ist eine riesige Datenbank mit Informationen über alle Websites im Internet.

Durch die Indexierung kann eine Suchmaschine schnell relevante Ergebnisse für eine bestimmte Anfrage liefern. Die Suchmaschine durchsucht den Index nach passenden Websites und zeigt diese dem Benutzer an.

Dank Crawling und Indexierung können Benutzer von Suchmaschinen schnell auf relevante Informationen zugreifen. Es ist jedoch wichtig zu beachten, dass es einige Zeit dauern kann, bis neue Inhalte in den Index aufgenommen werden. Es ist daher ratsam, regelmäßig neuen Content auf Ihrer Website zu veröffentlichen, um sicherzustellen, dass Ihre Website immer aktuell bleibt.

Insgesamt ermöglichen Crawling und Indexierung es Suchmaschinen, schnell relevante Ergebnisse für Benutzer bereitzustellen. Durch die Umsetzung einiger grundlegender Tipps zur Optimierung Ihrer Website können Sie sicherstellen, dass Ihre Seite leichter gefunden wird und höher in den Suchergebnissen erscheint.

Sie helfen bei der Erkennung von Duplikaten oder ähnlichem Content sowie beim Entfernen unerwünschter Elemente aus dem Index der Suchmaschine

Crawling und Indexierung: Die Vorteile bei der Erkennung von Duplikaten und unerwünschten Elementen

Crawling und Indexierung sind wichtige Prozesse, um sicherzustellen, dass Ihre Website von Suchmaschinen gefunden und in den Index aufgenommen wird. Doch diese Prozesse haben noch weitere Vorteile.

Einer dieser Vorteile ist die Erkennung von Duplikaten oder ähnlichem Content. Wenn Sie beispielsweise denselben Inhalt auf mehreren Seiten Ihrer Website haben, kann dies zu einer niedrigeren Platzierung in den Suchergebnissen führen. Durch das Crawling und die Indexierung Ihrer Website können Suchmaschinen solche Duplikate erkennen und entsprechend einordnen.

Ein weiterer Vorteil ist die Möglichkeit, unerwünschte Elemente aus dem Index der Suchmaschine zu entfernen. Wenn Sie beispielsweise eine Seite auf Ihrer Website haben, die nicht mehr relevant ist oder veraltet ist, möchten Sie möglicherweise verhindern, dass sie in den Suchergebnissen erscheint. Durch das Entfernen dieser Seite aus dem Index können Sie sicherstellen, dass sie nicht mehr angezeigt wird.

Zusammenfassend lässt sich sagen, dass Crawling und Indexierung nicht nur dazu dienen, Ihre Website für Suchmaschinen zu optimieren. Sie bieten auch wichtige Vorteile wie die Erkennung von Duplikaten oder ähnlichem Content sowie das Entfernen unerwünschter Elemente aus dem Index der Suchmaschine. Indem Sie diese Prozesse nutzen, können Sie sicherstellen, dass Ihre Website optimal in den Suchergebnissen platziert wird und potenzielle Besucher finden leicht zu Ihnen finden können.

Crawling und Indexierung kann sehr zeitaufwändig sein.

Obwohl Crawling und Indexierung wichtige Schritte sind, um sicherzustellen, dass Ihre Website von Suchmaschinen gefunden wird, kann es auch sehr zeitaufwändig sein. Bots müssen jede Seite Ihrer Website crawlen und analysieren, um sie in den Index aufzunehmen. Dies kann besonders bei größeren Websites sehr viel Zeit in Anspruch nehmen.

Es ist wichtig zu beachten, dass Bots nicht alle Seiten gleich oft crawlen. Je nachdem wie oft Ihre Seite aktualisiert wird oder wie viele Links darauf verweisen, kann es länger dauern, bis sie im Index erscheint. Es kann also einige Zeit dauern, bis Sie die Auswirkungen Ihrer Optimierungen sehen.

Es gibt jedoch Möglichkeiten, um den Prozess zu beschleunigen. Eine Möglichkeit ist die Verwendung von Sitemaps. Eine Sitemap ist eine Datei auf Ihrer Website, die alle Seiten enthält, die Sie in den Index aufnehmen möchten. Dadurch können Bots schneller und effizienter durch Ihre Website navigieren.

Ein weiterer Tipp ist die regelmäßige Aktualisierung Ihrer Website mit neuen Inhalten oder Änderungen an bestehenden Inhalten. Dies signalisiert Suchmaschinen-Bots, dass Ihre Seite aktiv ist und regelmäßig aktualisiert wird.

Insgesamt gilt: Obwohl Crawling und Indexierung zeitaufwändig sein können, sind sie unverzichtbar für eine erfolgreiche Suchmaschinenoptimierung. Mit einigen einfachen Tipps können Sie jedoch sicherstellen, dass der Prozess so effizient wie möglich abläuft.

Die Kosten für die Implementierung einer Crawler-Lösung sind oft hoch.

Ein Nachteil von Crawling und Indexierung ist, dass die Implementierung einer Crawler-Lösung oft mit hohen Kosten verbunden ist. Die Entwicklung einer solchen Lösung erfordert in der Regel spezielle Kenntnisse und Fähigkeiten, um sicherzustellen, dass sie effektiv und zuverlässig funktioniert. Es kann auch erforderlich sein, zusätzliche Hardware oder Software zu erwerben, um den Crawler auszuführen und die Daten zu speichern.

Darüber hinaus können die Kosten für den Betrieb des Crawlers ebenfalls hoch sein. Je nach Größe Ihrer Website und der Häufigkeit des Crawlings können die Kosten für Serverkapazitäten, Bandbreite und Speicherplatz schnell ansteigen. Dies kann insbesondere für kleinere Unternehmen oder einzelne Website-Betreiber eine Herausforderung darstellen.

Es ist daher wichtig, sorgfältig zu planen und abzuwägen, ob eine Crawler-Lösung wirklich notwendig ist und welche Kosten damit verbunden sind. Möglicherweise gibt es auch alternative Methoden zur Verbesserung der Sichtbarkeit Ihrer Website in Suchmaschinen, die weniger kostenintensiv sind.

Insgesamt sollten Sie bei der Entscheidung für eine Crawler-Lösung sowohl die Vorteile als auch die möglichen Kosten sorgfältig abwägen, um sicherzustellen, dass Sie das beste Ergebnis für Ihr Unternehmen erzielen.

Unter Umständen können Webseiten durch das Crawling und Indexieren beschädigt werden.

Obwohl Crawling und Indexierung wichtige Prozesse sind, um Ihre Website für Suchmaschinen zu optimieren, gibt es auch einige Nachteile. Einer davon ist, dass Ihre Website durch diese Prozesse beschädigt werden kann.

Wenn Bots Ihre Seite crawlen, können sie eine Menge Datenverkehr erzeugen. Wenn Ihre Website nicht dafür ausgelegt ist, kann dies zu einer Überlastung führen und dazu führen, dass Ihre Seite langsamer wird oder sogar abstürzt. Dies kann dazu führen, dass Besucher frustriert sind und Ihre Seite verlassen.

Ein weiteres Problem ist, dass Bots manchmal auf Links klicken, die zu fehlerhaften Seiten führen oder auf Seiten mit schädlichem Inhalt. Wenn dies geschieht, kann dies dazu führen, dass die Suchmaschine Ihre Seite als unsicher einstuft und sie aus dem Index entfernt.

Um diese Probleme zu vermeiden, sollten Sie sicherstellen, dass Ihre Website gut strukturiert ist und für den Datenverkehr von Bots ausgelegt ist. Sie sollten auch regelmäßig überprüfen, ob alle Links auf Ihrer Seite funktionieren und ob es keine schädlichen Inhalte gibt.

Zusammenfassend lässt sich sagen: Obwohl Crawling und Indexierung wichtige Prozesse sind, um die Sichtbarkeit Ihrer Website in Suchmaschinen zu erhöhen, sollten Sie auch die potenziellen Risiken im Auge behalten und sicherstellen, dass Ihre Website darauf vorbereitet ist.

Eine schlecht implementierte Crawler-Lösung kann zu unerwünschten Ergebnissen führen, da nicht alle Seiten richtig indexiert werden können.

Crawling und Indexierung können eine wertvolle Methode sein, um sicherzustellen, dass Ihre Website von Suchmaschinen gefunden wird. Allerdings gibt es auch einige Nachteile, die beachtet werden müssen. Eine schlecht implementierte Crawler-Lösung kann zu unerwünschten Ergebnissen führen, da nicht alle Seiten richtig indexiert werden können.

Wenn Sie beispielsweise eine Website mit vielen Unterseiten haben, kann es schwierig sein sicherzustellen, dass jeder einzelne Link von einem Bot gefunden wird. Wenn nicht alle Seiten indexiert werden können, kann dies dazu führen, dass wichtige Inhalte auf Ihrer Seite nicht in den Suchergebnissen erscheinen.

Es ist daher wichtig sicherzustellen, dass Ihre Crawler-Lösung korrekt implementiert ist und alle Seiten Ihrer Website erfasst werden. Dies kann durch die Verwendung von Sitemaps und Robots.txt-Dateien erreicht werden. Diese Dateien geben Bots Anweisungen darüber, welche Seiten auf Ihrer Website gecrawlt werden sollen und welche nicht.

Zusammenfassend lässt sich sagen, dass Crawling und Indexierung wichtige Methoden sind, um Ihre Website für Suchmaschinen zu optimieren. Allerdings sollten Sie sich bewusst sein, dass eine schlecht implementierte Lösung zu unerwünschten Ergebnissen führen kann. Es ist daher wichtig sicherzustellen, dass Ihre Crawler-Lösung korrekt implementiert ist und alle wichtigen Seiten Ihrer Website erfasst werden.

Es besteht die Gefahr, dass sensible Daten beim Crawling und Indexieren ausgespäht werden könnten, falls keine geeigneten Sicherheitsmaßnahmen getroffen wurden.

Ein Risiko beim Crawling und Indexieren von Websites besteht darin, dass sensible Daten ausgespäht werden können. Wenn keine geeigneten Sicherheitsmaßnahmen getroffen wurden, können Bots oder Spiders sensible Informationen wie Passwörter oder persönliche Daten sammeln und speichern.

Dies kann insbesondere dann ein Problem sein, wenn Ihre Website personenbezogene Daten enthält oder verarbeitet. In diesem Fall müssen Sie sicherstellen, dass Ihre Website entsprechend gesichert ist und dass nur autorisierte Personen Zugriff auf die Daten haben.

Es ist auch wichtig zu beachten, dass Suchmaschinen nicht die einzigen Bots sind, die Ihre Website crawlen können. Es gibt auch Bots von Hackern oder Malware-Programmen, die versuchen könnten, Schwachstellen in Ihrer Website auszunutzen.

Um dieses Risiko zu minimieren, sollten Sie geeignete Sicherheitsmaßnahmen ergreifen. Dazu gehört beispielsweise die Verwendung von HTTPS-Verschlüsselung für Ihre Website sowie das Implementieren von Firewalls und anderen Sicherheitsvorkehrungen.

Insgesamt ist es wichtig, sich der Risiken bewusst zu sein und geeignete Maßnahmen zu ergreifen, um sicherzustellen, dass Ihre Website und sensiblen Daten geschützt sind.

Wenn einmal etwas falsch indexiert wurde, ist es schwer, den Fehler zu beheben oder zu ändern

Ein Nachteil von Crawling und Indexierung ist, dass es schwierig sein kann, Fehler zu beheben oder Änderungen vorzunehmen, wenn eine Seite einmal falsch indexiert wurde. Wenn eine Suchmaschine Ihre Seite zum Beispiel aufgrund eines technischen Problems oder einer schlechten Strukturierung falsch einordnet, kann dies dazu führen, dass sie in den Suchergebnissen nicht so gut abschneidet wie sie sollte.

In solchen Fällen kann es schwierig sein, den Fehler zu beheben oder die Seite neu zu indexieren. Es kann einige Zeit dauern, bis Bots Ihre Seite erneut crawlen und aktualisieren. In der Zwischenzeit kann Ihre Seite in den Suchergebnissen weiterhin falsch angezeigt werden.

Um solche Probleme zu vermeiden, ist es wichtig, sicherzustellen, dass Ihre Website von Anfang an richtig strukturiert und optimiert ist. Überprüfen Sie regelmäßig Ihre Inhalte und Meta-Tags auf relevante Keywords und stellen Sie sicher, dass Ihre interne Verlinkung klar und logisch ist.

Wenn Sie jedoch feststellen, dass Ihre Seite immer noch falsch indexiert ist oder Probleme hat, sollten Sie sich an einen SEO-Experten wenden. Ein Experte kann Ihnen dabei helfen, das Problem zu identifizieren und Lösungen vorzuschlagen. Zusammen können Sie dann daran arbeiten, die Indexierung Ihrer Website zu verbessern und sicherzustellen, dass sie in den Suchergebnissen besser abschneidet.

Neueste Beiträge

- Optimieren Sie Ihre Website mit Yoast SEO: Die ultimative Lösung für bessere Suchmaschinenoptimierung

- Die besten Google SEO Tipps für eine erfolgreiche Website-Rankings

- Die Macht von Abakus SEO: Optimieren Sie Ihre Online-Präsenz heute!

- Optimierung der Offsite-Strategie: Maximieren Sie Ihre Online-Sichtbarkeit

- Die Bedeutung einer Einführung in Suchmaschinenoptimierung für Ihr Online-Marketing-Erfolg

Neueste Kommentare

Kategorien

- 2019

- amazon

- basel

- bergisch gladbach

- content marketing

- content optimierung

- elementor

- gambio

- google optimize

- google search

- google such

- h2

- h3

- herausfinden

- jimdo

- joomla

- joomla seo

- local seo

- magento

- offpage

- offpage seo

- oneproseo

- online marketing

- onpage

- onpage analyse

- onpage seo

- preis

- preise

- ranking check

- rankingcheck

- sea

- sem

- seo

- seo agentur münchen

- seo check

- seo firma

- seo spezialist

- seo tester online

- seomarketing

- service suchmaschinenoptimierung

- shopify

- shopware

- suchmaschinenmarketing

- suchmaschinenoptimierung

- suchmaschinenoptimierung berlin

- technische seo

- test

- typo3

- Uncategorized

- webdesign

- webseitenoptimierung

- wix

- wordpress

- wordpress seo

- wpml

- xovi

- yoast

- yoast seo